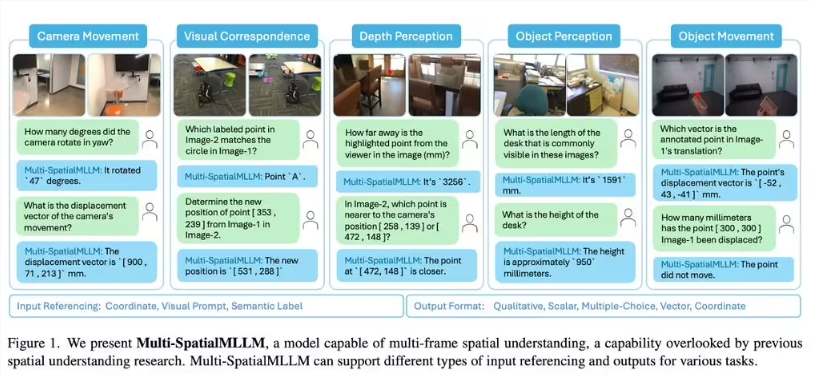

大家好,今天给大家带来一个超酷的科技进展!Meta 与香港中文大学联合发布了一款全新模型——Multi-SpatialMLLM。这款多模态大语言模型(MLLMs)在空间理解领域实现了质的飞跃,特别是在复杂视觉任务中表现出色。

随着机器人和自动驾驶技术的发展,对空间理解的需求越来越高,但传统模型往往存在明显的短板。比如,在区分左右方向这种基础任务上,现有模型的表现让人头疼。究其原因,主要是缺乏针对性训练数据,且传统方法大多依赖静态视角分析,难以处理动态信息。

为了解决这些问题,研究团队推出了 MultiSPA 数据集,包含超过2700万个样本,覆盖多样化3D 和4D 场景。同时,他们设计了五个关键训练任务,包括深度感知、相机移动感知和物体大小感知等,进一步强化模型的空间推理能力。

经过一系列测试,Multi-SpatialMLLM 的表现堪称惊艳:在 MultiSPA 基准测试中,平均提升了36%,定性任务准确率高达80-90%;而在 BLINK 基准测试中,准确率接近90%,超越多个专有系统。更值得一提的是,即使面对高难度任务如预测相机移动向量,该模型也能达到18% 的准确率。

划重点:

Multi-SpatialMLLM 模型通过整合深度感知、视觉对应和动态感知三大组件,彻底突破单帧图像分析限制。

它不仅在多项基准测试中表现卓越,还展现了强大的通用能力,真正实现了性能与实用性的完美结合。

📝留言定制 (0)